春節(jié)期間,國產(chǎn)大模型 DeepSeek R1 憑借開源特性和高效推理能力成為 AI 領(lǐng)域的焦點。其知識蒸餾技術(shù)能將復(fù)雜模型的推理能力遷移至輕量化版本,使其在多項基準(zhǔn)測試中表現(xiàn)優(yōu)異,甚至超越部分國際頂尖模型。開源策略+輕量設(shè)計,不僅降低了 AI 部署門檻,更為邊緣計算場景帶來了全新的可能。

春節(jié)后首個工作日,InHand AI 技術(shù)團隊成功在 EC5000系列邊緣計算機上完成 DeepSeek R1 蒸餾模型的本地部署。這一成果驗證了輕量級邊緣設(shè)備(如 EC5000)在 AI 推理任務(wù)中的強大潛力。相較于傳統(tǒng)云端部署,邊緣端計算無需依賴高算力服務(wù)器,可在低功耗環(huán)境下實現(xiàn)實時推理,為工業(yè)質(zhì)檢、智慧交通、遠(yuǎn)程醫(yī)療等領(lǐng)域提供更靈活、安全、高效的AI 解決方案。

通過幾個簡單的步驟,就可以實現(xiàn)在EC5000系列邊緣計算機上運行DeepSeek R1 蒸餾模型。

步驟1:安裝Nvidia的jetson containers工具包

通過以下兩條命令完成jetson containers工具包的下載和安裝:

git clone https://github.com/dusty-nv/jetson-containers

bash jetson-containers/install.sh

步驟2:安裝Nvidia Jetpack工具包

通過以下兩條命令完成Nvidia Jetpack工具包的下載和安裝:

sudo apt update

sudo apt install nvidia-jetpack

步驟3:修改Docker鏡像倉庫源為中國大陸國內(nèi)源(非必須)

在目錄 /etc/docker/ 下創(chuàng)建文件daemon.json。

在文件daemon.json中輸入以下內(nèi)容并保存(以vim編輯器為例):

sudo vim /etc/docker/daemon.json

{

"registry-mirrors": [

"https://docker.1ms.run",

"https://docker.xuanyuan.me"

]

}

保存文件后,通過以下命令重啟Docker服務(wù),使配置文件生效

sudo systemctl daemon-reload

sudo systemctl restart docker

注意:

1.https://docker.1ms.run 和https://docker.xuanyuan.me兩個docker鏡像源地址僅保證在2025年2月5日可用,如果服務(wù)器失效,需要將地址修改為當(dāng)前可用的服務(wù)器地址。

2. 此步驟非必須,僅當(dāng)默認(rèn)docker倉庫地址不可用時,自定義鏡像倉庫地址用于加速。中國大陸以外的用戶,一般不需要執(zhí)行此步驟。

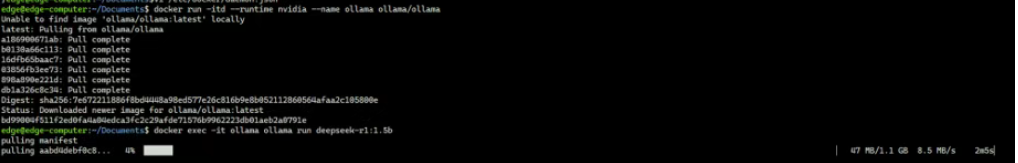

步驟4:下載并運行ollama容器

docker run -itd --runtime nvidia --name ollama ollama/ollama

步驟5:通過ollama 下載并運行deepseek r1的蒸餾模型

參考連接:https://ollama.com/library/deepseek-r1:1.5b

選擇要運行的Deepseek R1 蒸餾模型版本,然后通過ollama 命令行自動安裝。以DeepSeek-R1-Distill-Qwen-1.5B模型為例,執(zhí)行下面的命令:

docker exec -it ollama ollama run deepseek-r1:1.5b

其中,參數(shù)deepseek-r1:1.5b為模型名,可替換為其它想要運行的模型名稱(參考https://ollama.com/search)。命令執(zhí)行后,系統(tǒng)將自動下載并安裝參數(shù)指定的模型。

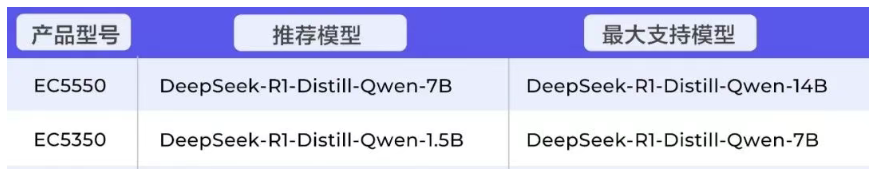

下表列出了EC5000系列邊緣計算機支持的DeepSeek R1 蒸餾模型情況:

驗證模型

執(zhí)行命令docker exec -it ollama ollama run deepseek-r1:1.5b(deepseek-r1:1.5b 需要替換為用戶自己使用的模型名稱)后,便可以和模型交互。

![]()

其它

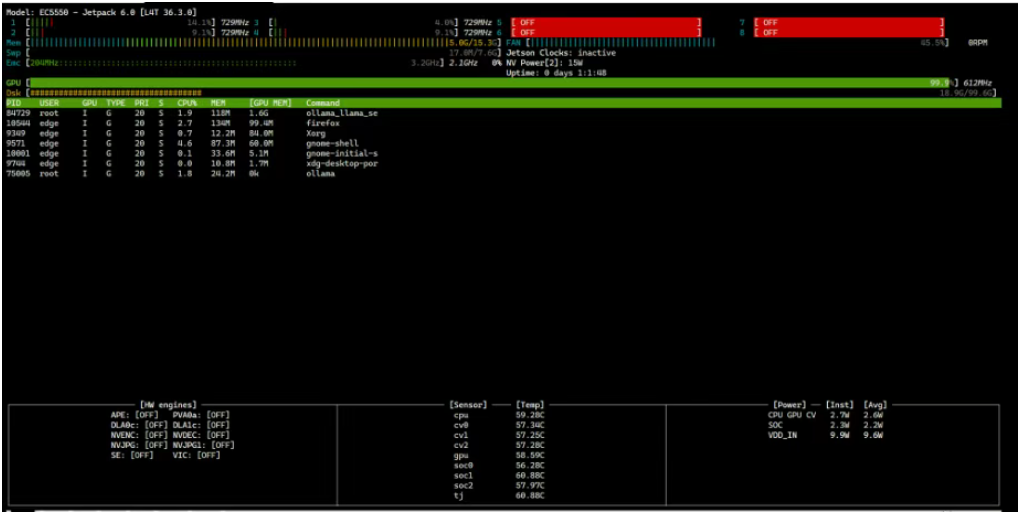

查看EC5000系列邊緣計算機的CPU/GPU/內(nèi)存利用率

設(shè)備支持通過jtop命令實時查看本設(shè)備硬件狀態(tài),執(zhí)行sudo jtop 后,將會看到下圖所示的輸出:

注意:jtop命令必須通過root權(quán)限執(zhí)行。

說明

1. 除了示例中的deepseek R1 蒸餾模型外,EC5000系列邊緣計算機也支持其它開源的LLM,如llama3等。

2. 通過ollama在EC5000系列邊緣計算機中運行LLM方法并不是唯一的。

此次在EC5000系列邊緣計算機上成功部署DeepSeek R1蒸餾模型,不僅驗證了邊緣硬件與前沿AI技術(shù)的深度融合能力,更開啟了“輕量化+高性能”的邊緣AI新范式。

未來,隨著蒸餾技術(shù)的持續(xù)優(yōu)化,企業(yè)可基于此類方案快速構(gòu)建私有化AI服務(wù),降低算力成本的同時保障數(shù)據(jù)安全。InHand 將持續(xù)推動邊緣智能生態(tài)建設(shè),助力千行百業(yè)邁向“端側(cè)智慧化”的新階段。

資訊頻道

資訊頻道